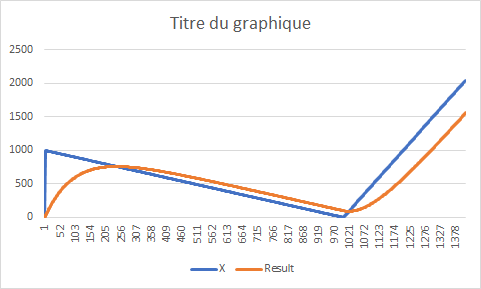

j’ai fait un test récursif sur excel avec 9500 valeurs et selon moi, le coefficient sur plusieurs milliers de valeurs provoque une latence très élevée dans certains cas.

exemple : un niveau baissant très lentement tout au long des heures (cas d’une fuite) puis remontant rapidement en 1 heure (remplissage) sera largement minimisé à la fin du remplissage. J’obtiens des écarts jusqu’à 50 % dans certains cas, bien sûr je n’ai pas des valeurs réalistes pour faire le test. Mais cela tend tout de même à vérifier le fait que si une tendance à la baisse dure plus longtemps qu’une tendance à la hausse, le niveau final est minimisé trop fortement. L’inertie est d’autant plus importante que le ratio de temps des 2 périodes est élevé.

Pour des valeurs variant beaucoup dans la journée, ce lissage peut convenir, je n’en doute pas, mais pour des valeurs ayant des variations lentes puis rapides, le résultat risque d’induire en erreur. Le problème de cette méthode, c’est que le résultat de la fonction est influencé par toutes les mesures effectuées depuis le démarrage de l’ipx800 et non pas sur une fenêtre de temps glissant « autour » de la mesure.

Ma conclusion serait que cette méthode peut ne pas fonctionner dans certains cas, c’est juste une petite note d’attention pour les lecteurs ![]()

Une autre méthode permettait d’éliminer des mesures au fil du temps, en morcelant les périodes de mesures.

Cette approche avait été abordée dans ce tuto pour le calcul de la vitesse du vent dans ce tuto